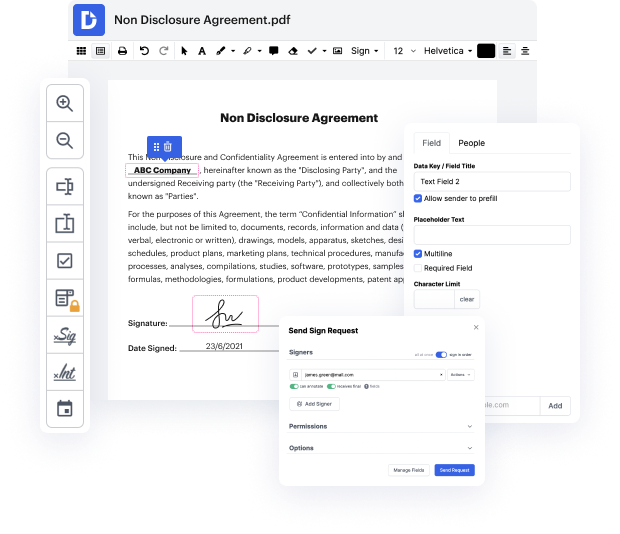

El mercado de edición de documentos de hoy en día es enorme, por lo que encontrar una solución adecuada que satisfaga tus necesidades y tus expectativas de precio-calidad puede llevar tiempo y esfuerzo. No hay necesidad de perder tiempo navegando por la web buscando un editor versátil pero fácil de usar para Tack URL en un archivo Csv. DocHub está aquí a tu disposición siempre que lo necesites.

DocHub es un editor de documentos en línea de renombre mundial en el que confían millones. Puede satisfacer casi cualquier demanda de los usuarios y cumple con todas las certificaciones de seguridad y cumplimiento requeridas para garantizar que tus datos estén bien protegidos mientras cambias tu archivo Csv. Considerando su rica e intuitiva interfaz ofrecida a un precio asequible, DocHub es una de las opciones más beneficiosas que existen para una gestión de documentos optimizada.

DocHub proporciona muchas otras capacidades para una edición de documentos efectiva. Por ejemplo, puedes convertir tu formulario en una plantilla de uso múltiple después de editar o crear una plantilla desde cero. ¡Explora todas las características de DocHub ahora!

hola a todos, así que como pueden ver hoy vamos a extraer una lista de urls de un csv y mi suscriptor quiere extraer el texto de todas las páginas de todos los sitios, así que dice que todos los datos que realmente busca son todos los textos. ¿cómo puedo extraer todas las páginas y subpáginas de la lista de urls en el csv? he encontrado un método pero eso solo funciona para una página de inicio. ¿puede alguien reprogramar y decirme cómo extraer todos los datos de a un sitio web? ya que no podemos usar xpath para cada url, en realidad le proporcioné esto originalmente y, um, con beautiful soup funcionó bien, no hay problema. el problema era que él quería el texto de todas las páginas y no solo de la primera página, así que lo que he hecho en su lugar es otra cosa, no puedo realmente pensar en otra idea, así que si les gustaría ver eso, um, esta es la lista de urls, así que no quiero mostrarlas demasiado de cerca para no revelar el juego, pero um, tenemos uh 469 urls um, en realidad he sido un poco astuto y he usado vim para eliminar

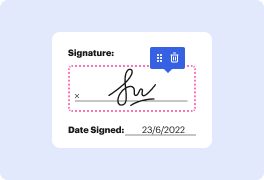

En DocHub, la seguridad de tus datos es nuestra prioridad. Seguimos HIPAA, SOC2, GDPR y otros estándares, para que puedas trabajar en tus documentos con confianza.

Aprende más