La generación y aprobación de documentos son, sin duda, un enfoque central de cada organización. Ya sea manejando grandes volúmenes de archivos o un acuerdo específico, necesitas mantenerte en la cima de tu productividad. Encontrar una plataforma en línea perfecta que aborde tus problemas más comunes de generación y aprobación de documentos podría resultar en bastante trabajo. Muchas aplicaciones en línea te ofrecen solo una lista mínima de características de edición y firma electrónica, algunas de las cuales podrían ser útiles para manejar el formato csv. Una solución que maneje cualquier formato y tarea podría ser una opción excepcional al elegir software.

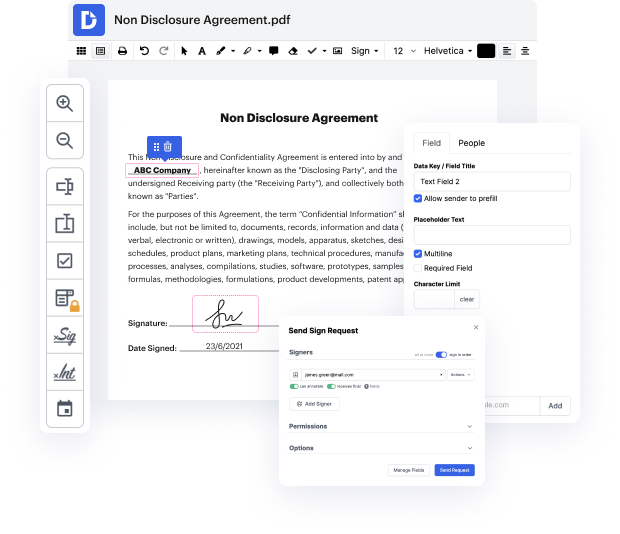

Lleva la gestión y generación de archivos a un nuevo nivel de eficiencia y excelencia sin optar por una interfaz incómoda o un plan de suscripción costoso. DocHub te ofrece herramientas y características para manejar eficientemente todos los tipos de archivos, incluyendo csv, y realizar tareas de cualquier dificultad. Cambia, organiza y crea formularios rellenables reutilizables sin esfuerzo. Obtén completa libertad y flexibilidad para deslizar URL en csv en cualquier momento y almacena de forma segura todos tus documentos completos dentro de tu perfil de usuario o en una de las muchas aplicaciones de almacenamiento en la nube integradas posibles.

DocHub ofrece edición sin pérdida, recolección de firmas y gestión de csv a niveles profesionales. No necesitas pasar por tutoriales tediosos y gastar horas y horas descubriendo el software. Haz que la edición de archivos segura de primer nivel sea un proceso habitual para tus flujos de trabajo diarios.

hola a todos, así que como pueden ver hoy vamos a raspar una lista de urls de un csv y mi suscriptor quiere extraer el texto de todas las páginas de todos los sitios, así que dice que todos los datos que realmente busca son todos los textos. ¿Cómo puedo extraer todas las páginas y subpáginas de la lista de urls en el csv? He encontrado un método pero eso solo funciona para una página de inicio. ¿Puede alguien volver a codificar y decirme cómo extraer todos los datos de a un sitio web ya que no podemos usar xpath para cada url? De hecho, le proporcioné esto originalmente y, um, con beautiful soup funcionó bien, sin problema. El problema era que él quería el texto de todas las páginas y no solo de la primera página. Así que lo que he hecho en su lugar es otra cosa, no puedo realmente encontrar otra idea, así que si les gustaría ver eso, um, esta es la lista de urls, así que no quiero mostrarlas demasiado de cerca para no revelar el juego, pero um, tenemos uh 469 urls um, de hecho he sido un poco astuto y he usado vim para eliminar o

En DocHub, la seguridad de tus datos es nuestra prioridad. Seguimos HIPAA, SOC2, GDPR y otros estándares, para que puedas trabajar en tus documentos con confianza.

Aprende más