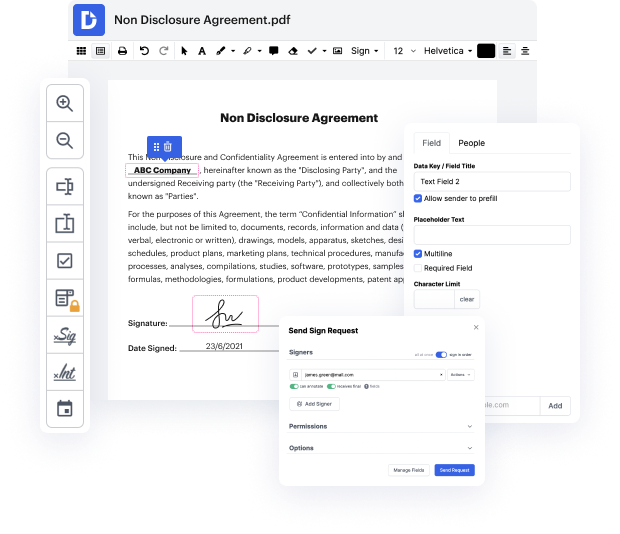

Hay muchas herramientas de edición de documentos en el mercado, pero solo unas pocas son adecuadas para todos los formatos de archivo. Algunas herramientas son, por el contrario, versátiles pero difíciles de usar. DocHub proporciona la respuesta a estos desafíos con su editor basado en la nube. Ofrece funcionalidades robustas que te permiten completar tus tareas de gestión de documentos de manera eficiente. Si necesitas revisar rápidamente la URL en Csv, ¡DocHub es la opción ideal para ti!

Nuestro proceso es muy sencillo: subes tu archivo Csv a nuestro editor → se transforma automáticamente en un formato editable → aplicas todos los cambios necesarios y lo actualizas profesionalmente. Solo necesitas unos minutos para tener tu documentación lista.

Tan pronto como se apliquen todas las alteraciones, puedes transformar tu documentación en una plantilla reutilizable. Solo necesitas ir al Menú del lado izquierdo de nuestro editor y hacer clic en Acciones → Convertir en Plantilla. Encontrarás tu documentación almacenada en una carpeta separada en tu Tablero, ahorrándote tiempo la próxima vez que necesites la misma plantilla. ¡Prueba DocHub hoy!

hola a todos, así que como pueden ver hoy vamos a eextraer una lista de urls de un csv y mi suscriptor quiere extraer el texto de todas las páginas de todos los sitios, así que dice que todos los datos que realmente busca son todos los textos. ¿Cómo puedo eextraer todas las páginas y subpáginas de la lista de urls en el csv? He encontrado un método, pero eso solo funciona para una página de inicio. ¿Puede alguien reprogramar y decirme cómo extraer todos los datos de a un sitio web, ya que no podemos usar xpath para cada url? De hecho, le proporcioné esto originalmente y, um, con beautiful soup funcionó bien, sin problema. El problema era que él quería el texto de todas las páginas y no solo de la primera página. Así que lo que he hecho en su lugar es otra cosa, no puedo realmente pensar en otra idea, así que si les gustaría ver eso, um, esta es la lista de urls, así que no quiero mostrarlas demasiado de cerca para no revelar el juego, pero um, tenemos uh 469 urls um, de hecho he sido un poco astuto y he usado vim para eliminar

En DocHub, la seguridad de tus datos es nuestra prioridad. Seguimos HIPAA, SOC2, GDPR y otros estándares, para que puedas trabajar en tus documentos con confianza.

Aprende más