Cuando el alcance de tus tareas diarias incluye mucha edición de documentos, ya sabes que cada formato de documento requiere su propio enfoque y a veces software particular. Manejar un archivo ACL que parece simple puede a menudo detener todo el proceso, especialmente cuando intentas editar con herramientas insuficientes. Para prevenir tales dificultades, consigue un editor que cubra tus necesidades sin importar la extensión del archivo y el tipo de incrustación en ACL sin obstáculos.

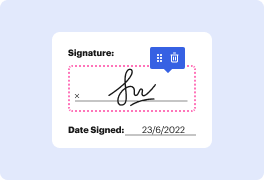

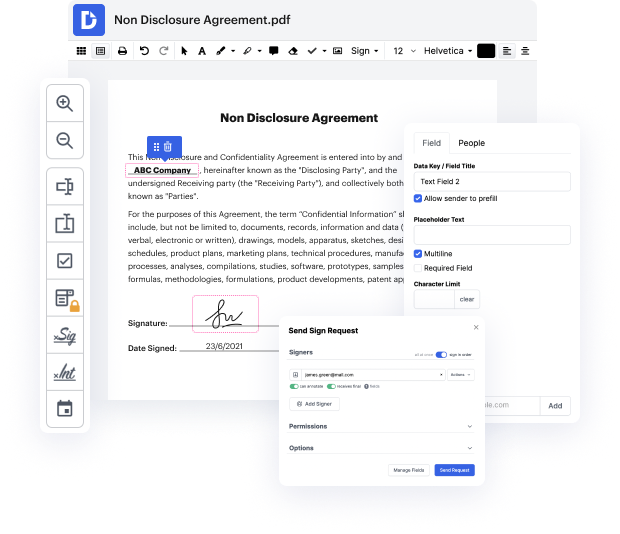

Con DocHub, vas a trabajar con una herramienta de edición multifuncional para prácticamente cualquier situación o tipo de documento. Minimiza el tiempo que solías invertir en navegar por las características de tu antiguo software y aprende de nuestra interfaz intuitiva mientras realizas el trabajo. DocHub es una plataforma de edición en línea elegante que cubre todas tus necesidades de procesamiento de documentos para prácticamente cualquier archivo, incluyendo ACL. Ábrelo y ve directamente a la productividad; no se necesita capacitación previa ni leer instrucciones para disfrutar de los beneficios que DocHub aporta a la gestión de documentos. Comienza tomando un par de minutos para registrar tu cuenta ahora.

Observa mejoras en el procesamiento de tus documentos justo después de abrir tu perfil de DocHub. Ahorra tiempo en la edición con nuestra única solución que te ayudará a ser más productivo con cualquier formato de archivo con el que necesites trabajar.

hola, mi nombre es Simran y soy estudiante de doctorado en la Universidad de Stanford en el grupo de Chris Ray. Hoy estoy emocionada de hablarles sobre un estudio para comprender mejor el valor de los encabezados contextuales. El reciente desarrollo de incrustaciones de palabras conductivas ricas, como Alvin Burt, ha revolucionado el procesamiento del lenguaje natural, permitiendo un progreso rápido y benchmarks populares como glue y saying, así como un uso industrial generalizado. Estas incrustaciones están entrenadas para modelar el contexto en el que aparece una palabra en una oración y, aunque las incrustaciones contextuales funcionan increíblemente bien, son altamente costosas computacionalmente tanto en el tiempo de entrenamiento como en el de inferencia, ya que generalmente consisten en varias capas de módulos transformadores. Por ejemplo, al usar el modelo base de verbos, extraer las incrustaciones de palabras para los tokens en una oración toma del orden de 10 milisegundos en una GPU y requiere almacenar cientos de megabytes de parámetros del modelo y gigabytes de activaciones del modelo si las incrustaciones están siendo ajustadas. En este trabajo nos enfocamos en la pregunta o