Elegir la solución ideal de gestión de documentos para la organización puede llevar tiempo. Necesitas evaluar todos los matices de la plataforma que te interesa, evaluar los planes de precios y estar al tanto de los estándares de protección. Sin duda, la oportunidad de manejar todos los formatos, incluyendo csv, es vital al considerar una solución. DocHub proporciona una amplia lista de capacidades y herramientas para manejar con éxito tareas de cualquier complejidad y ocuparse del formato csv. Obtén un perfil de DocHub, configura tu espacio de trabajo y comienza a trabajar en tus documentos.

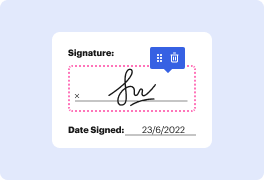

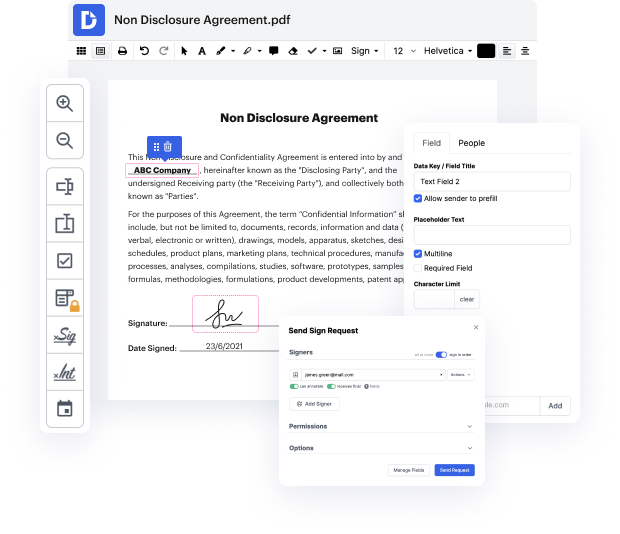

DocHub es un programa completo todo en uno que te permite editar tus documentos, firmarlos electrónicamente y crear plantillas reutilizables para los formularios más utilizados. Ofrece una interfaz de usuario intuitiva y la oportunidad de manejar tus contratos y acuerdos en formato csv de manera simplificada. No tienes que preocuparte por leer numerosas guías y sentirte estresado porque el software es demasiado complejo. cancelar URL en csv, asignar campos rellenables a destinatarios específicos y recoger firmas sin esfuerzo. DocHub se trata de capacidades poderosas para profesionales de todos los ámbitos y necesidades.

Mejora tus operaciones de generación y aprobación de documentos con DocHub hoy. Benefíciate de todo esto utilizando una versión de prueba gratuita y actualiza tu perfil cuando estés listo. Modifica tus documentos, crea formularios y descubre todo lo que puedes hacer con DocHub.

hola a todos, como pueden ver hoy vamos a raspar una lista de urls de un csv y mi suscriptor quiere extraer el texto de todas las páginas de todos los sitios, así que dice que todos los datos que realmente busca son todos los textos. ¿Cómo puedo extraer todas las páginas y subpáginas de la lista de urls en el csv? He encontrado un método, pero eso solo funciona para una página de inicio. ¿Puede alguien volver a codificar y decirme cómo extraer todos los datos de a un sitio web? ya que no podemos usar xpath para cada url, en realidad le proporcioné esto originalmente y, um, con beautiful soup funcionó bien, sin problemas. El problema era que él quería el texto de todas las páginas y no solo de la primera página. Así que lo que he hecho en su lugar es otra cosa, no puedo realmente pensar en otra idea, así que si les gustaría ver eso, um, esta es la lista de urls, así que no quiero mostrarlas demasiado de cerca para no revelar el juego, pero, um, tenemos uh 469 urls um, en realidad he sido un poco astuto y he usado vim para eliminar o

En DocHub, la seguridad de tus datos es nuestra prioridad. Seguimos HIPAA, SOC2, GDPR y otros estándares, para que puedas trabajar en tus documentos con confianza.

Aprende más