Cuando tu trabajo diario consiste en mucha edición de documentos, sabes que cada formato de documento requiere su propio enfoque y, a menudo, software específico. Manejar un archivo WRD que parece simple puede detener todo el proceso, especialmente si intentas editar con herramientas insuficientes. Para evitar tales problemas, encuentra un editor que pueda cubrir tus requisitos sin importar la extensión del archivo y añade un token en WRD sin obstáculos.

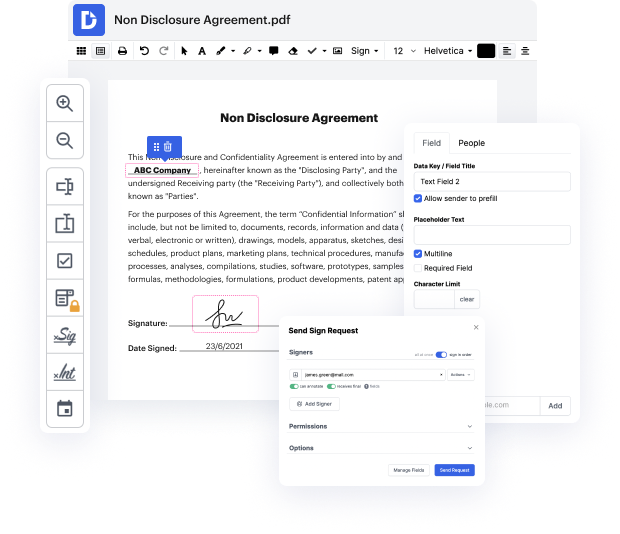

Con DocHub, trabajarás con una herramienta de edición multifuncional para prácticamente cualquier ocasión o tipo de documento. Reduce el tiempo que solías invertir en navegar por las características de tu antiguo software y aprende de nuestro diseño de interfaz intuitivo mientras realizas el trabajo. DocHub es una plataforma de edición en línea elegante que maneja todos tus requisitos de procesamiento de documentos para prácticamente cualquier archivo, incluyendo WRD. Ábrelo y ve directamente a la eficiencia; no se necesita capacitación previa ni leer manuales para aprovechar los beneficios que DocHub aporta a la gestión de documentos. Comienza dedicando unos momentos a registrar tu cuenta ahora.

Observa mejoras en el procesamiento de tus documentos justo después de abrir tu perfil de DocHub. Ahorra tiempo en la edición con nuestra única plataforma que te ayudará a ser más productivo con cualquier formato de documento con el que necesites trabajar.

cuando estábamos construyendo sistemas de nlp la entrada no son palabras o incluso oraciones sino más bien solo secuencias de caracteres toma este ejemplo de orgullo y prejuicio si solo lo dividiéramos por espacios obtendríamos esta secuencia de palabras donde tenemos tres instancias de i que difieren porque la puntuación aún está adjunta así que realizamos la tokenización que convierte una secuencia de caracteres en una secuencia de tokens al usar un tokenizador estándar en este texto obtenemos esta secuencia que ha separado la puntuación de las palabras y también ha dividido la contracción im en i y apóstrofe m así que ahora nuestras tres instancias de i lucen iguales la mayoría de los tokenizadores son basados en reglas diseñados manualmente por hablantes de un idioma pero hay diferentes convenciones de tokenización una diferencia en inglés es cómo se manejan las contracciones por ejemplo así es como lucen dos convenciones de tokenización para algunas contracciones en inglés ninguna parece perfecta dont y arent son tal vez mejor manejadas por la convención del banco de despensa porque t