Formatos de archivo inusuales dentro de sus operaciones diarias de gestión y edición de documentos pueden crear confusión instantánea sobre cómo editarlos. Puede que necesite más que el software de computadora preinstalado para una edición de documentos eficiente y rápida. Si necesita limpiar texto en HWP o hacer cualquier otra alteración básica en su documento, elija un editor de documentos que tenga las características para trabajar con facilidad. Para manejar todos los formatos, incluido HWP, optar por un editor que realmente funcione correctamente con todo tipo de documentos es su mejor opción.

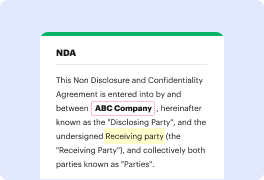

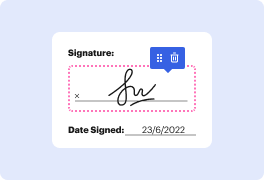

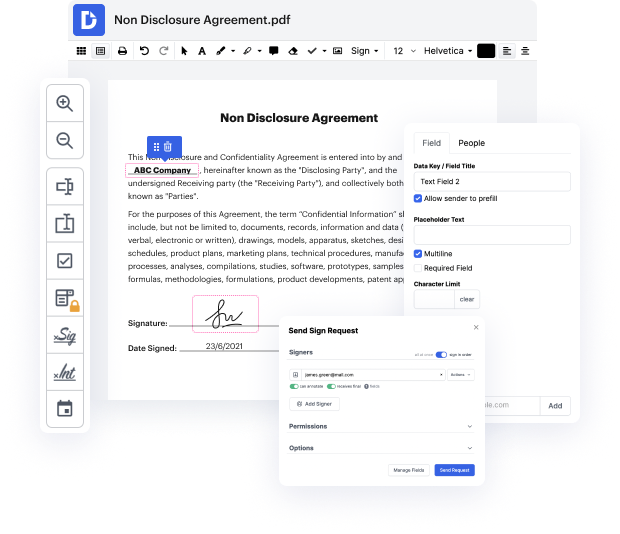

Pruebe DocHub para una gestión de documentos efectiva, independientemente del formato de su documento. Tiene potentes herramientas de edición en línea que agilizan sus operaciones de gestión de documentos. Es fácil crear, editar, anotar y compartir cualquier documento, ya que todo lo que necesita para acceder a estas características es una conexión a internet y un perfil de DocHub en funcionamiento. Solo una solución de documento es todo lo que necesita. No pierda tiempo saltando entre diferentes aplicaciones para diferentes documentos.

Disfrute de la eficiencia de trabajar con una herramienta hecha específicamente para agilizar el procesamiento de documentos. Vea lo sencillo que realmente es modificar cualquier documento, incluso cuando es la primera vez que ha tratado con su formato. Regístrese ahora y mejore todo su proceso de trabajo.

hola la limpieza de texto es una de las principales actividades en un pipeline de procesamiento de lenguaje natural a veces los datos del mundo real son muy desordenados que pasarás la mayor parte del tiempo limpiando el texto antes de prepararlo y alimentarlo al modelo así que en este video vamos a ver algunos métodos y funciones que puedes usar para limpiar datos de nlp ahora será una combinación de funciones escritas a medida y en algunos casos serán paquetes que están listos para usar en tu pipeline de nlp así que empecemos así que en este caso lo que voy a hacer es que voy a usar el conocido conjunto de datos fetch 20 news groups el conjunto de datos de 20 news groups está disponible como parte del conjunto de datos de scikit-learn así que solo estoy importando de scikit-learn conjuntos de datos importar fetch 20 news cube 20 news group y luego lo que estoy haciendo es que solo estoy tomando el conjunto de datos de entrenamiento de él hay una prueba también pero solo voy a usar el conjunto de datos de entrenamiento lo estoy asignando a newsgroup underscore train solo estoy importando