No todos los formatos, como TXT, están desarrollados para ser fácilmente editados. A pesar de que muchas características pueden ayudarnos a ajustar todos los formatos de documentos, nadie ha creado aún una herramienta real que sirva para todos los tamaños.

DocHub proporciona una herramienta simple y optimizada para editar, cuidar y almacenar documentos en los formatos más utilizados. No tienes que ser una persona experta en tecnología para trabajar en peculiaridad en TXT o hacer otras modificaciones. DocHub es lo suficientemente robusto como para hacer que el proceso sea fácil para todos.

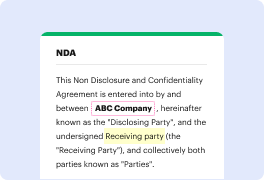

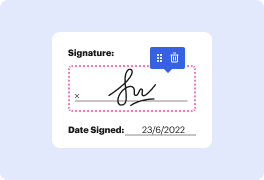

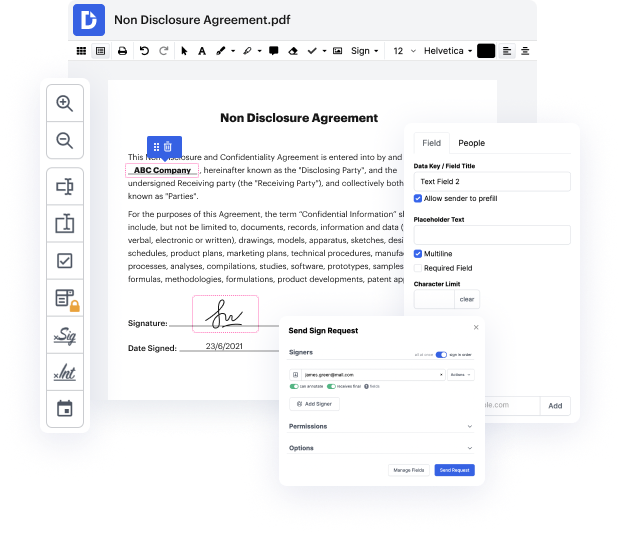

Nuestra herramienta te permite alterar y ajustar documentos, enviar datos de un lado a otro, crear documentos interactivos para la recolección de datos, encriptar y proteger documentos, y configurar flujos de trabajo de firma electrónica. Además, también puedes generar plantillas a partir de documentos que utilizas de manera regular.

Encontrarás muchas herramientas adicionales dentro de DocHub, como integraciones que te permiten vincular tu documento TXT a varias aplicaciones de productividad.

DocHub es una opción intuitiva y rentable para manejar documentos y optimizar flujos de trabajo. Ofrece una amplia gama de capacidades, desde la creación hasta la edición, proveedores de firma electrónica y creación de formularios web. El software puede exportar tus archivos en múltiples formatos mientras mantiene la máxima protección y sigue los más altos requisitos de protección de datos.

Pruébalo y descubre lo fácil que puede ser tu proceso de edición.

hola soy Victoria y en este video vamos a discutir qué es el archivo robots.txt, cómo funciona y cómo crearlo en un sitio web de WordPress. Vamos a optimizar mejor tu sitio web, necesitas asegurarte de que los Bots de los motores de búsqueda puedan rastrear tus páginas más importantes. Para ayudarte en ese proceso, hay un archivo llamado robots.txt, que ayuda a dirigir a los Bots de los motores de búsqueda a las páginas web que deseas que indexen. robots.txt es un archivo que contiene instrucciones para los robots de los motores de búsqueda, diciéndoles que rastreen o eviten páginas web, archivos subidos o parámetros de URL. En palabras simples, el archivo robots.txt le dice a los rastreadores: 'hey, puedes mirar esta parte del sitio web, pero no vayas allí'. Para entender cómo puede beneficiar la optimización de tu sitio web, hablemos sobre el proceso de rastreo de los motores de búsqueda. Cuando alguien crea un nuevo sitio web, los motores de búsqueda envían sus rastreadores para descubrir y recopilar la información necesaria para indexar una página. Una vez que el rastreador web encuentra información como palabras clave y f