Buscar una herramienta especializada que maneje formatos particulares puede ser un proceso que consume tiempo. A pesar de la gran cantidad de editores en línea disponibles, no todos ellos soportan el formato Csv, y definitivamente no todos te permiten hacer ajustes a tus archivos. Para empeorar las cosas, no todos ellos proporcionan la seguridad que necesitas para proteger tus dispositivos y documentación. DocHub es una gran respuesta a estos desafíos.

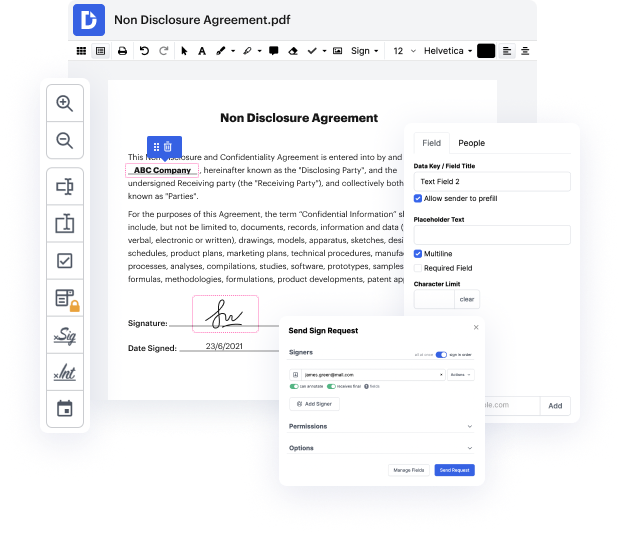

DocHub es una solución en línea popular que cubre todas tus necesidades de edición de documentos y protege tu trabajo con una protección de datos a nivel empresarial. Soporta varios formatos, incluyendo Csv, y te ayuda a editar dicha documentación de manera fácil y rápida con una interfaz rica y amigable para el usuario. Nuestra herramienta cumple con certificaciones de seguridad cruciales, como GDPR, CCPA, PCI DSS y Google Security Assessment, y sigue mejorando su cumplimiento para proporcionar la mejor experiencia de usuario. Con todo lo que ofrece, DocHub es la forma más confiable de Revisar página en archivo Csv y gestionar toda tu documentación personal y empresarial, independientemente de cuán sensible sea.

Después de completar todos tus ajustes, puedes establecer una contraseña en tu Csv editado para asegurarte de que solo los destinatarios autorizados puedan abrirlo. También puedes guardar tu documentación que contenga un Registro de Auditoría detallado para ver quién hizo qué cambios y a qué hora. Elige DocHub para cualquier documentación que necesites ajustar de forma segura. ¡Regístrate ahora!

[Música] ¿quieres crear un proyecto secundario que utilice contenido de otros sitios web o quieres recopilar información y verificar cuándo se actualiza, como comprobar si el precio fluctúa en un producto que deseas a lo largo del tiempo? Tal vez quieras almacenar información de un sitio web y manipularla dentro de un archivo csv. Estas son todas aplicaciones de programación que implicarían web scraping. El web scraping es una aplicación de programación extremadamente poderosa y versátil que te permite recopilar, almacenar y manipular información presentada en un sitio web. Hoy voy a explicar el proceso de cómo hacer un web scraper en python utilizando las bibliotecas beautiful soup y request, que luego formatea los datos recopilados en un archivo csv. El sitio web con el que estaré demostrando esto es las tarifas de envío listadas en el sitio web de Canada Post, un caso de uso simple donde puede que quieras comprobar rápidamente cuáles son las tarifas de envío actuales, especialmente si cambian durante el transcurso del año. Así que para comenzar el programa let