Ya sea que estés acostumbrado a trabajar con TXT o que manejes este formato por primera vez, editarlo no debería parecer un desafío. Diferentes formatos pueden requerir aplicaciones específicas para abrirlos y editarlos correctamente. Sin embargo, si necesitas vincular rápidamente resultados en TXT como parte de tu proceso habitual, es recomendable encontrar una herramienta multifuncional de documentos que permita todo tipo de operaciones sin necesidad de esfuerzo adicional.

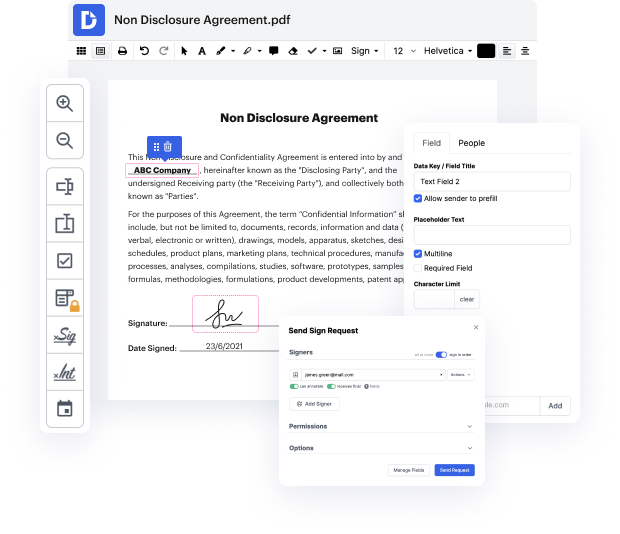

Prueba DocHub para una edición elegante de TXT y otros formatos de archivo. Nuestra plataforma proporciona un procesamiento de documentos sin esfuerzo, sin importar cuánta o poca experiencia previa tengas. Con las herramientas que necesitas para trabajar en cualquier formato, no tendrás que saltar entre ventanas de edición al trabajar con cada uno de tus documentos. Crea, edita, anota y comparte tus documentos sin esfuerzo para ahorrar tiempo en tareas de edición menores. Solo necesitarás registrarte en una nueva cuenta de DocHub, y luego podrás comenzar tu trabajo de inmediato.

Observa una mejora en la eficiencia de la gestión de documentos con el conjunto de características simples de DocHub. Edita cualquier archivo rápida y fácilmente, sin importar su formato. Disfruta de todas las ventajas que provienen de la eficiencia y conveniencia de nuestra plataforma.

queridos estudiantes, bienvenidos a otro tutorial de ciencia de datos con python. en este tutorial en particular, vamos a aprender sobre el web scraping en acción. en la siguiente demostración, les voy a mostrar cómo raspar una página web y guardar sus resultados en un archivo externo. así que, ¡comencemos! este archivo de jupyter lab ya está cargado con las bibliotecas estándar para beautiful soup, así que tienen beautiful soup y también tienen url lib y re ya importados. pueden encontrar el enlace al archivo en la sección de descripción. el enlace los redirigirá a un sitio web donde pueden encontrar este cuaderno de jupyter. así que lo que vamos a hacer es raspar una página de analytics.usa.gov. vamos a crear una variable r y luego vamos a decir que r es igual a url lib punto request punto url open y vamos a pasar nuestra url a nuestra función url open aquí. así que solo vamos a crear una cadena que lea https analytics.usa.jov y lo que queremos hacer es continuar y leer d

En DocHub, la seguridad de tus datos es nuestra prioridad. Seguimos HIPAA, SOC2, GDPR y otros estándares, para que puedas trabajar en tus documentos con confianza.

Aprende más