Las personas que trabajan diariamente con diferentes documentos saben muy bien cuánto depende la productividad de lo conveniente que sea acceder a las herramientas de edición. Cuando los archivos de Evaluación del Desempeño de los Estudiantes deben guardarse en un formato diferente o incorporar componentes complejos, puede ser un desafío manejarlos utilizando editores de texto convencionales. Un simple error en el formato podría arruinar el tiempo que dedicaste a enlazar fotos en la Evaluación del Desempeño de los Estudiantes, y una tarea tan básica no debería sentirse desafiante.

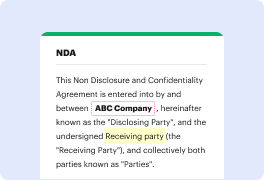

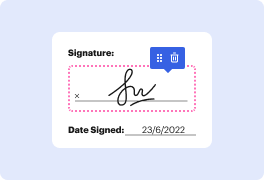

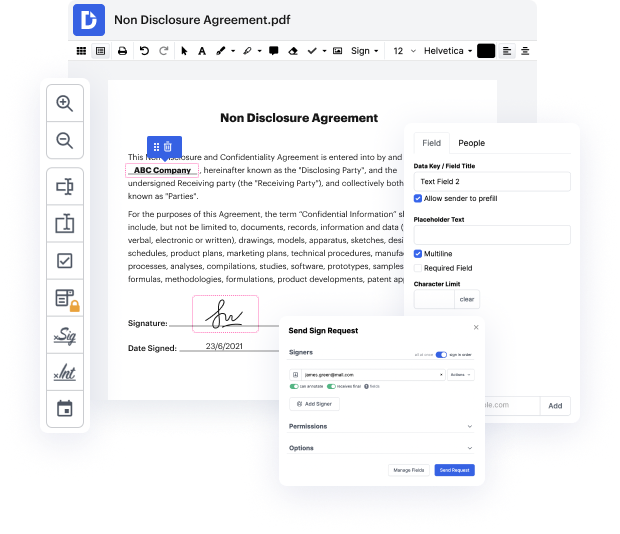

Cuando encuentras una herramienta multifuncional como DocHub, este tipo de preocupaciones de ninguna manera aparecerán en tu trabajo. Esta poderosa solución de edición basada en la web puede ayudarte a manejar fácilmente documentos guardados en la Evaluación del Desempeño de los Estudiantes. Puedes crear, modificar, compartir y convertir tus documentos fácilmente desde cualquier lugar. Todo lo que necesitas para usar nuestra interfaz es una conexión a internet estable y una cuenta de DocHub. Puedes registrarte en minutos. Aquí te mostramos lo fácil que puede ser el proceso.

Usando una solución de edición bien desarrollada, gastarás un tiempo mínimo descubriendo cómo funciona. Comienza a ser productivo en el momento en que abras nuestro editor con una cuenta de DocHub. Nos aseguraremos de que tus herramientas de edición preferidas estén siempre disponibles cuando las necesites.

El paso final de este pipeline es evaluar qué tan bueno es nuestro modelo a través de la evaluación del desempeño. La evaluación de modelos predictivos es uno de los pasos más cruciales en el pipeline. La idea básica es desarrollar el modelo utilizando algunas muestras de entrenamiento, pero probar este modelo de entrenamiento en algunas otras muestras no vistas, idealmente de datos futuros. Es importante notar que el error de entrenamiento no es muy útil, porque puedes sobreajustar muy fácilmente los datos de entrenamiento utilizando modelos complejos que no generalizan bien a muestras futuras. El error de prueba es la métrica clave porque es una mejor aproximación del verdadero desempeño del modelo en muestras futuras. El enfoque clásico para la evaluación es a través del proceso de validación cruzada o CV. La idea principal detrás de la validación cruzada es dividir iterativamente un conjunto de datos en conjuntos de entrenamiento y validación. Y queremos ver el modelo en el conjunto de entrenamiento, y probar el modelo en el paso de validación, pero hacer esto iterativamente, muchas veces.