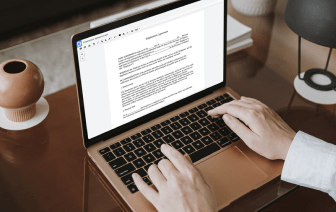

La generación y aprobación de documentos son, sin duda, un enfoque central de cada organización. Ya sea manejando grandes volúmenes de documentos o un contrato específico, debes mantenerte en la cima de tu productividad. Encontrar una excelente plataforma en línea que aborde tus problemas más comunes de creación y aprobación de documentos puede resultar en mucho trabajo. Muchas plataformas en línea ofrecen solo una lista mínima de funciones de edición y firma, algunas de las cuales podrían ser útiles para manejar el formato de archivo xml. Una solución que maneje cualquier formato de archivo y tarea podría ser una opción excepcional al elegir software.

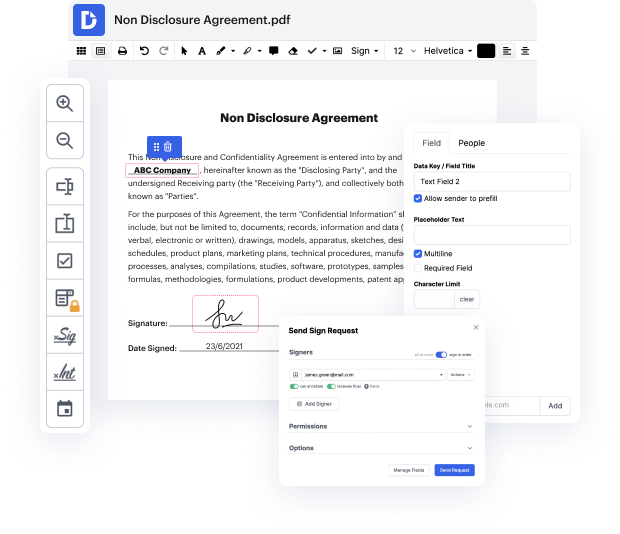

Lleva la gestión y creación de documentos a otro nivel de simplicidad y sofisticación sin elegir una interfaz incómoda o opciones de suscripción costosas. DocHub te ofrece herramientas y características para manejar con éxito todos los tipos de documentos, incluyendo xml, y realizar tareas de cualquier complejidad. Edita, organiza y produce formularios rellenables reutilizables sin esfuerzo. Obtén completa libertad y flexibilidad para terminar la hoja en xml en cualquier momento y almacena de forma segura todos tus archivos completos dentro de tu cuenta o en una de las muchas plataformas de almacenamiento en la nube integradas posibles.

DocHub ofrece edición sin pérdida, recolección de firmas y gestión de xml a niveles profesionales. No necesitas pasar por tutoriales agotadores e invertir horas y horas descubriendo la aplicación. Haz que la edición de documentos seguros de primer nivel sea un proceso habitual para los flujos de trabajo diarios.

en este video vamos a repasar cómo usar la función importar xml para hacer web scraping en google sheets. usar la función importar xml me ha permitido crear algunos de mis rastreadores de portafolio y hojas de cálculo de valoración de acciones como las que ves aquí, así que vamos a entrar en el tutorial. bien, lo primero que vamos a hacer es aprender a hacer web scraping usando la función importar xml y luego vamos a aprender a automatizar el proceso de web scraping usando importar xml. así que puedes ver que lo primero que queremos hacer es obtener datos de wikipedia y puedes ver que actualmente estamos viendo la página de wikipedia de kobe bryant y si desplazo hacia abajo, los datos que queremos obtener en nuestra hoja de cálculo son qué número usó kobe bryant en su camiseta, que fue 8 y 24. así que lo que vamos a hacer es volver a nuestra hoja de cálculo y aquí es donde voy a realizar la función importar xml, así que para hacer esto vamos a poner un