Cuando el alcance de tus tareas diarias incluye mucha edición de documentos, te das cuenta de que cada formato de documento requiere su propio enfoque y, en algunos casos, software específico. Manejar un archivo TXT aparentemente simple puede a menudo detener todo el proceso, especialmente cuando intentas editar con software inadecuado. Para evitar tales dificultades, encuentra un editor que cubra todas tus necesidades sin importar el formato del archivo y borra oraciones en TXT sin obstáculos.

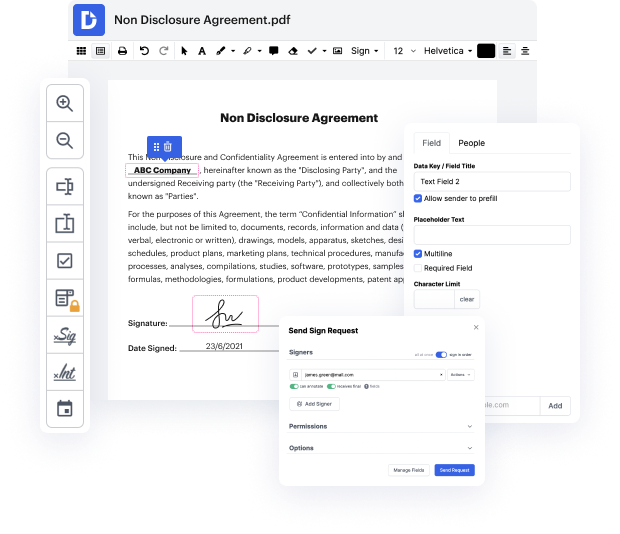

Con DocHub, vas a trabajar con una herramienta de edición multifuncional para prácticamente cualquier situación o tipo de documento. Reduce el tiempo que solías gastar navegando por la funcionalidad de tu antiguo software y aprende de nuestra interfaz de usuario intuitiva mientras realizas el trabajo. DocHub es una plataforma de edición en línea elegante que maneja todas tus necesidades de procesamiento de documentos para prácticamente cualquier archivo, como TXT. Ábrelo y ve directamente a la eficiencia; no se requiere capacitación previa ni lectura de guías para disfrutar de los beneficios que DocHub aporta a la gestión de documentos. Comienza dedicando unos minutos a registrar tu cuenta ahora.

Observa mejoras en el procesamiento de tus documentos justo después de abrir tu perfil de DocHub. Ahorra tiempo en la edición con nuestra única plataforma que te ayudará a ser más productivo con cualquier formato de documento con el que necesites trabajar.

uh hola comunidad hoy quiero hablarles sobre por qué el embedding de oraciones en esports no es el embedding de vectores de oraciones de BERT para dejarlo absolutamente claro, voy a mostrarles la diferencia entre el modelo de s part versus el modelo de vectores de oraciones de BERT. Así que aquí vamos. Si no has visto mi video sobre el vector de palabras de BERT y el vector de oraciones de BERT, un resumen muy corto en un minuto: ¿qué es BERT? BERT se basa en un transformador, pero solo utiliza el codificador del transformador y es una pila de codificadores. Como puedes ver aquí a la izquierda, tenemos 12 codificadores apilados uno encima del otro y les damos una entrada que viene desde abajo y tenemos una oración, por supuesto, la oración es ¿cómo estás? Y sabes que, dado que es BERT, tenemos una tokenización específica de word piece. Tenemos una clasificación al principio de cada una de las oraciones, este es el cls, luego tenemos una capa de embedding donde todas nuestras palabras se comparan o se traducen a una representación numérica en nuestro vocabulario y luego tenemos

En DocHub, la seguridad de tus datos es nuestra prioridad. Seguimos HIPAA, SOC2, GDPR y otros estándares, para que puedas trabajar en tus documentos con confianza.

Aprende más