No todos los formatos, como TXT, están creados para ser fácilmente editados. A pesar de que muchas características nos permitirán modificar todos los formatos de documentos, nadie ha inventado aún una solución real que sirva para todos.

DocHub proporciona una solución fácil y simplificada para editar, manejar y almacenar documentos en los formatos más utilizados. No tienes que ser una persona con conocimientos técnicos para borrar URL en TXT o hacer otros ajustes. DocHub es lo suficientemente potente como para hacer que el proceso sea simple para todos.

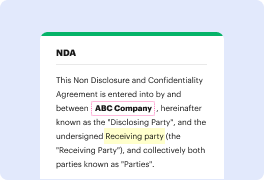

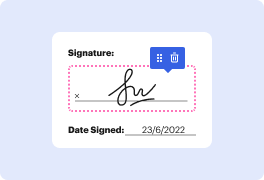

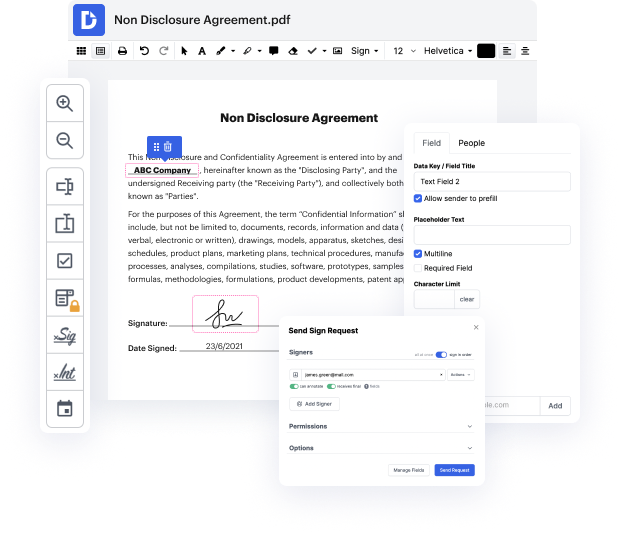

Nuestra herramienta te permite alterar y ajustar documentos, enviar datos de un lado a otro, generar documentos dinámicos para la recopilación de información, cifrar y proteger formularios, y configurar flujos de trabajo de firma electrónica. Además, también puedes crear plantillas a partir de documentos que usas regularmente.

Encontrarás muchas herramientas adicionales dentro de DocHub, como integraciones que te permiten vincular tu documento TXT a una amplia variedad de aplicaciones empresariales.

DocHub es una forma sencilla y rentable de gestionar documentos y mejorar flujos de trabajo. Proporciona una amplia selección de herramientas, desde la creación hasta la edición, proveedores de firma electrónica y desarrollo de documentos web. La aplicación puede exportar tus archivos en muchos formatos mientras mantiene la máxima protección y sigue los más altos criterios de seguridad de la información.

Pruébalo y descubre lo simple que puede ser tu proceso de edición.

así que un archivo robots.txt correcto ayuda a que tu sitio web se indexe mejor y más rápido en motores de búsqueda como Google y también reduce el número de errores en la consola de búsqueda de Google. El archivo robots.txt es un conjunto de instrucciones para los rastreadores web. Estos rastreadores web son enviados por Google para analizar tu sitio web y luego indexar las páginas de tu sitio web en el motor de búsqueda. Y con robots.txt podemos establecer algunas instrucciones o una guía que le dice a estos robots qué páginas del sitio web deben procesar y qué páginas del sitio web deben dejar y no molestarse con ellas o no intentar acceder a esas páginas. En este tutorial de robots.txt vamos a aprender sobre las siguientes cosas: qué es robots.txt y por qué deberíamos usar el archivo robots.txt, cómo crear un archivo robots.txt perfecto y veremos cómo escribir instrucciones para que los motores de búsqueda sigan. Luego hablaremos sobre cuál es el mejor archivo robots.txt para diferentes plataformas como WordPress, Blogger, Wix, Shopify, Webflow, porque el concepto de robots.txt ar